På talefot med datamaskinen

Datamaskiner skal bli mer forståelsesfulle. De skal ta hensyn til hvem du er, hva du sier og hvordan du sier det. Dialogen med maskinene må utvides til å omfatte fakter og tonefall, og eksempler på slike programmer ble vist her på AAAS-konferansen i Boston.

Denne artikkelen er over ti år gammel og kan inneholde utdatert informasjon.

James Glass viste to programmer som er utviklet ved laboratoriet for kunstig intelligens ved Massachusetts Institute of Technology (MIT).

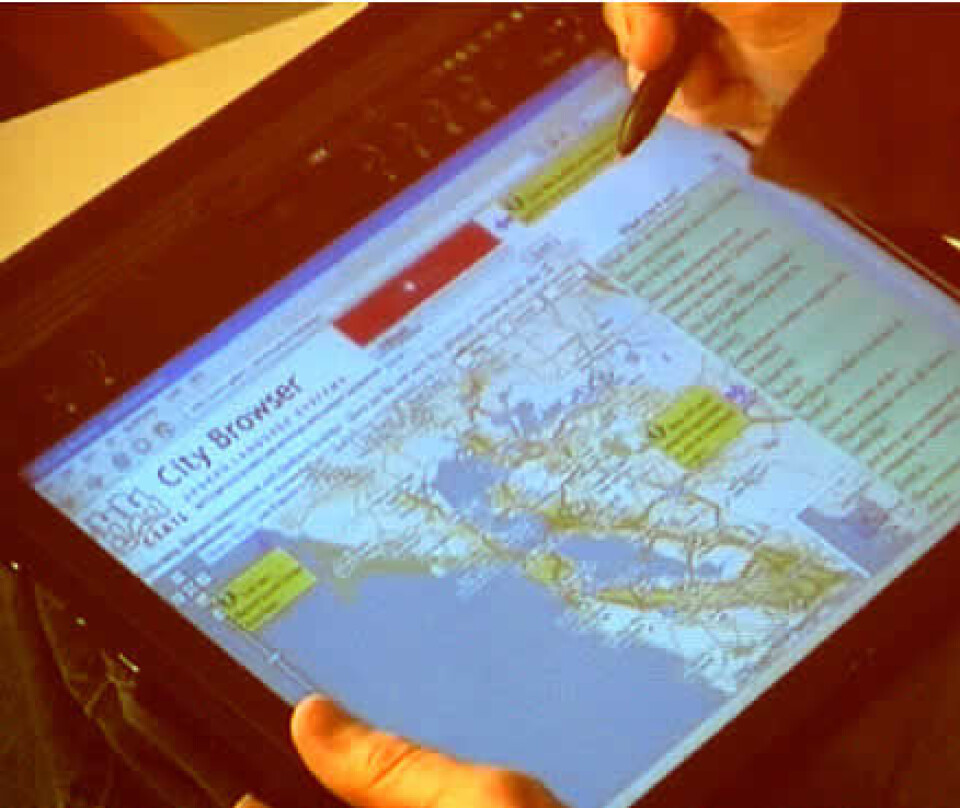

Det ene programmet fungerte sammen med internettprogrammet Google Maps. På en håndholdt datamaskin kunne brukeren snakke til datamaskinen og tegne på kartet på den trykkfølsomme skjermen for å understreke hva han mente.

Dette var et første enkelt forsøk på å bringe gestikulering inn i samtalen mellom menneske og maskin.

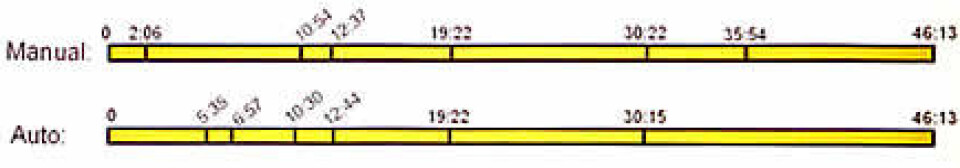

Det andre programmet analyserte videoopptak av forelesninger, tolket hva som ble sagt, delte det inn i avsnitt, laget nøkkelord for hvert avsnitt og gjorde innholdet søkbart.

Likeverdige partnere

Felles for de to programmene er en talegjenkjenning som er mye mer forståelsesfull enn den de fleste av oss møter i automatiserte telefonsvaresystemer.

- Muntlig språk er den vanligste formen for språk vi bruker, og vi bruker det svært uttrykksfullt. Vi bør gjøre det mulig å kommunisere muntlig med maskiner, mente Glass.

Han tegnet en akse der dagens primitive telefonsvaresystemer er i det ene ytterpunktet. Her er det maskinen som har styringen, og mennesket trekkes etter ørene gjennom en serie ja-nei-spørmål og skal si minst mulig.

I det andre ytterpunktet ligger full muntlig ytringsfrihet til mennesket uten hensyn til den stakkars maskinen som skal henge med i de verbale svingene.

Idealet til James Glass var midtpunktet på linja, det vil si en dialog der menneske og maskin var likverdige og tok hensyn til hverandres behov.

Den skitne virkeligheten

Problemet i følge Glass er at mange talegjenkjenningssystemer er blitt programmert i sterile laboratorier der folk snakker pent og rent. Det Glass og kollegene hans har gjort, er å dra talegjenkjenningen ut i den skitne virkeligheten.

- Prosjektet startet med et gratis telefonnummer der forsøkspersonene kunne ringe inn og få informasjon, fortalte Glass.

- Vi fikk opptak av alle lag av folket, alle slags dialekter, menn, kvinner og barn. Barn elsket disse eksperimentene, og var vår store skrekk i begynnelsen. Men barn har denne fine egenskapen at de er utholdende og sta, og de er så glade når de først får det til, sa Glass.

Ertet systemet

Innringerne var ikke alltid like snille med systemet. I utgangspunktet skulle de stille spørsmål om været og temperaturen i forskjellige byer, men de brukte fantasien til å lure datamaskinen opp i stry.

- Min favoritt er dette spørsmålet: Hva er temperaturen på en død kropp som har ligget i San Fransisco-bukta i tre uker, fortalte Jim Glass.

Mange innringere satte også systemet på prøve ved å hviske eller rope eller ringe fra barer og andre bråkete omgivelser. Men på denne måten lærte Glass og kollegene hans mange harde lekser om hvordan folk virkelig snakker.

Tolke sammenhenger

Men det er ikke nok å få maskinene til å forstå ordene. De må også kunne tolke ordene i en sammenheng.

Glass og kollegene flyttet etterhvert eksperimentene til Internett. De tok i bruk en liten programsnutt som samarbeidet med dataprogrammet Google Maps, og lot forsøkspersonene bruke nettleseren istedenfor telefonen.

Resultatet ble programmet City Browser. City Browser er laget slik at det tilpasser seg hva du sier, og husker tidligere deler av samtalen.

Hvis du for eksempel er interessert i kunstmuseer i en bydel, vil programmet foreslå lignende steder i andre bydeler også uten at du trenger å spørre om det en gang til.

- Vi kan finjustere vokabularet og forandre forventningene til hva brukeren kommer til å si, forklarte Glass.

Effektive fakter

City Browser kan også forstå gestikulering på et enkelt nivå. Programmet bruker en trykkfølsom skjerm, og brukeren kan peke og tegne på skjermen for å understreke hva han mener.

- En gest er noen ganger en mye mer effektiv måte å kommunisere på enn å snakke. Hvis jeg tegner en sirkel og spør: Er det noen restauranter i denne delen av byen, så trenger jeg mye færre ord, sa Glass.

Han mente at maskinene på lang sikt må bli mer lærevillige.

- Hver av oss bør kunne lære maskinene våre om slikt vi bryr oss om: nye begreper, nye framgangsmåter og så videre, sa han.

Bilde forsterker lyden

Glass mente også at ved å kombinere video og lyd, så kunne maskinen enda lettere forstå og tolke det som blir sagt.

- Lyd og video inneholder informasjon om hvor personen er, hvem de er og om de er forvirrede, sinte eller opprørte, sa Glass.

Han fortalte om et prosjekt der talegjenkjenning ble kombinert med bildegjenkjenning. Kombinasjonen av de to teknologiene reduserte feilraten til en tiendedel.

Søkbare forelesninger

Tolkningen av video og lyd sammen kan også brukes til å katalogisere videoopptak. James Glass og kollegene ved MITs laboratorium for kunstig intelligens har også utviklet et program som analyserer forelesninger.

Flere og flere slike forelesninger legges ut på nett og blir tilgjengelige for almenheten. Hvis brukerne kan søke i disse forelesningene, er det et stort framskritt.

I et tidligere prosjekt hadde forskere ved MIT analysert og katalogisert en bestemt fysikk-forelesning nøye.

Glass og kollegene hans utviklet prototypen til sitt program ved å la den øve seg på den samme forelesningen. En av utfordringene var å tilpasse talegjenkjenningen til de vidt forskjellige faguttrykkene i forskjellige forelesninger. Et annet problem var alt det ikke-verbale som foregikk i forelesningssalen.

MIT Lecture Browser

Nå er 200 forelesninger katalogisert med denne prototypen. MIT Lecture Browser er fritt tilgjengelig på Internett.

Du kan søke på innhold, se nøkkelord eller hoppe fra avsnitt til avsnitt. Lecturebrowser kobler også forelesningen opp mot den aktuelle læreteksten, og du ser teksten mens ordene sies. Dette øker forståeligheten kraftig.

Arbeidet med å gjøre maskiner mer forståelsesfulle er en stor internasjonal dugnad der både forskningsinstitusjoner og databedrifter deltar. De to programmene til Jim Glass viser hvor langt utviklingen er kommet i øyeblikket.

- Det er på tide at vi lager maskinene ut fra menneskenes behov. La folk snakke naturlig til maskiner, så tror jeg vi kan gjøre innhold mer tilgjengelig, avsluttet James Glass.

Lenker

Demonstrasjon av City Browser på YouTube

MIT Lecture Browser