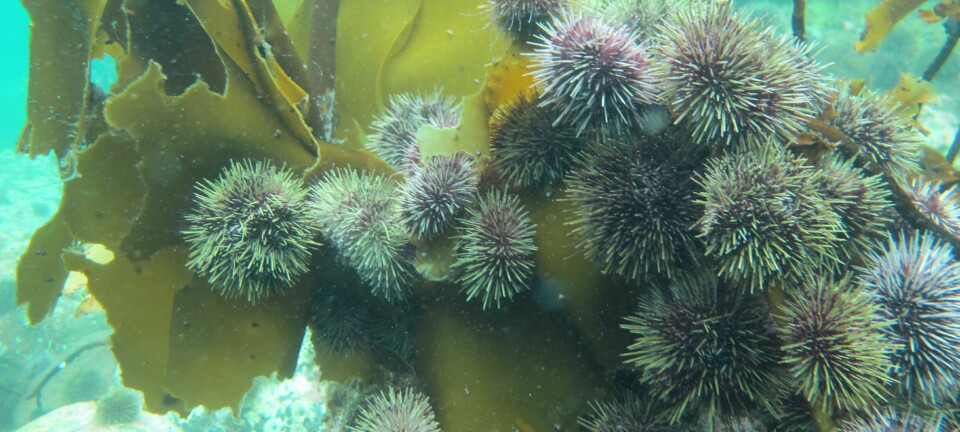

– Diskriminering i algoritmer er vanskelig fordi det er vi mennesker som diskriminerer, og vår forskjellsbehandling blir det værende i dataene vi gir fra oss, skriver Morten Goodwin.

(Illustrasjon: Shutterstock / NTB)

En stråmannsdiskusjon om AI-mytene

DEBATT: Dersom noen skulle finne på å overvåke en folkegruppe for fremtidig kriminalitet er det problematisk i seg selv. Det er like feil å gjøre det med kunstig intelligens som med helt annen teknologi, også penn og papir.

I et debattinnlegg av Michael Riegler, Pierre Lison, Inga Strümke og Anders Løland fra SimulaMet og Norsk Regnesentral, blir jeg beskyldt for å «overforenkle til det uvitenskapelige». De hevder at jeg skriver «at det er enkelt å unngå diskriminering, at forklarbarhet er enkelt og at personvernet ikke er i fare», og at «etiske og samfunnsmessige dimensjoner [kan] løsrives fra helheten, og [...] undergraves».

Disse uttalelsene skal angivelig ha kommet fra kronikker jeg har skrevet, og aller mest fra min ferske bok, AI. Myten om maskinene. Det stemmer ikke. Det er uttalelser jeg ikke kjenner meg igjen i. Resultatet blir en stråmannsdiskusjon.

Personvern

Jeg skriver aldri i boken (eller noe annet sted), at «personvernet ikke er i fare». Kapittelet «Det digitale diktatur» handler nettopp om de store personvernsutfordringene som kommer med kunstig intelligens. Jeg sier derimot at når algoritmene overvåker og får hemningsløs tilgang til personlig data, er det ikke en konsekvens av kunstig intelligens i seg selv. Slik inngripen skyldes menneskelig igangsatt overvåking.

Forklarbar kunstig intelligens handler om metoder som kan forklare resultatene fra AI-algoritmene for oss mennesker, og er en viktig del av personvernlovgivningen. I motsetning til det de skriver i innlegget, hevder jeg heller ikke at «forklarbarhet er enkelt». Faktisk sier jeg det helt motsatte, og jeg kan sitere fra min egen bok: «Vi står på kanten av et stup hvor dataalgoritmer har utviklet seg til å bli så avanserte [...] at det er vanskelig å forstå avgjørelsene som er tatt».

Riegler, Lison, Strümke og Løland blander to retninger av AI-forskningen: Forståelse av hva algoritmene gjør, og forklaring algoritmene kan gi oss mennesker. Vi har veldig god kontroll på hvordan AI-algoritmene fungerer, og hvordan de kommer frem til resultatene de faktisk gjør, også i de avanserte dype læringsmodellene. Stegene frem er typisk avanserte, vanskelig for lekmenn å følge, og er derfor til liten nytte å presentere reelle behandlingssituasjoner. Det mangler derfor mye forskning for å få algoritmene til å forklare avgjørelsene for oss mennesker. Vår forståelse av hva algoritmene gjør er ikke det samme som deres evner til å forklare seg selv.

Når debattantene nevner språkmodellers kompleksitet eksplisitt, foreslår jeg at de tar en ekstra titt på kapittelet «Den snakkende AI» som handler nettopp om hvor vanskelig det er for AI å lære seg språk, hvor ustabilt dette er, og om hvorfor PR-stuntene med snakkende roboter vi ser i media stort sett bare er tull og fjas.

Etikk

Jeg har heller aldri hevdet at «etiske dimensjoner [kan] løsrives fra helheten». Det kunne ikke vært lenger unna sannheten. Også her er det et helt kapittel som handler om nettopp om AIs manglende etiske forståelse og behovet for at samfunnet passer på: «AI ute av kontroll».

Deres sammenligning av problematisk AI-bruk med våpenindustrien er hårreisende. Pistoler lages for å drepe. AI, derimot, kan brukes til veldig gode formål, som medisinsk diagnostikk og proteinfolding, men også til onde formål, som automatiske våpen.

Diskriminering

Jeg har heller ikke påstått at «det er enkelt å unngå diskriminering», og foreslår at de leser underkapittelet «Når målet er diskriminering» en gang til. Der presenterer jeg mange eksempler på AI som diskriminerer og hvor vanskelig det er å løse.

Diskriminering i algoritmer er vanskelig fordi det er vi mennesker som diskriminerer, og vår forskjellsbehandling blir det værende i dataene vi gir fra oss. Når vi opplever at trente AI-algoritmer utilsiktet diskriminerer, slik som i en ansettelsesprosess, skyldes det dataene. AI-algoritmene blir ikke bedre enn dataene den er matet med. Å løse problemet involverer ofte store samfunnsmessige tilpassinger, som å få kvinner inn i flere lederstillinger. Å unngå en diskriminerende AI-algoritmer handler derimot om å passe på at dataene den er trent med er likestilt.

Innleggsforfatterne forsøker å vise at AI-diskriminering ikke alltid skyldes dataene, og presenterer et tenkt eksempel hvor en algoritme forutsier om muslimske tenåringer blir kriminelle. Det er riktig at en slik horribel algoritme ikke trenger data for å være problematisk. Eksempelet har derimot ingen ting å gjøre med kunstig intelligens. Dersom noen skulle finne på å overvåke en folkegruppe for fremtidig kriminalitet er det problematisk i seg selv, og det er like feil å gjøre det med kunstig intelligens som med helt annen teknologi, også penn og papir.

Enkelt forklart er ikke det samme som uvitenskapelig

Jeg er enig i ett utsagn fra debattinnlegget: Boken jeg nettopp har publisert, har en enkel forklaring av kunstig intelligens-algoritmene. Akkurat dette har vært hensikten. Boken er ment for mannen og kvinnen i gata, og jeg har der aldri i boken hatt som ambisjon å beskrive algoritmene i avansert matematisk detalj. Dette sier jeg klart fra om allerede i innledningen. Dersom de forventet programkode og matematikk har de kjøpt feil bok.